В киберпространстве несколько лет продолжается новая борьба «щита» и «меча» — совершенствование алгоритмов, создающих дипфейк-видео и определяющих подделку. Судя по всему, в этой войне наметился перелом, и он не в пользу «сил света». Исследователи экспериментально подтвердили возможность обмануть любое существующее решение для выявления поддельных роликов.

Как пишет портал SciTechDaily со ссылкой на работу американских специалистов по компьютерной инженерии, новая нейросеть довольно простым образом «обманывает» любые детекторы дипфейков. Этот алгоритм был представлен на Зимней конференции по применению компьютерного зрения, которая прошла в январе этого года (WACV 2021). Исследователи настаивают, что их решение демонстрирует неэффективность даже самых совершенных существующих средств определения подлинности видео.

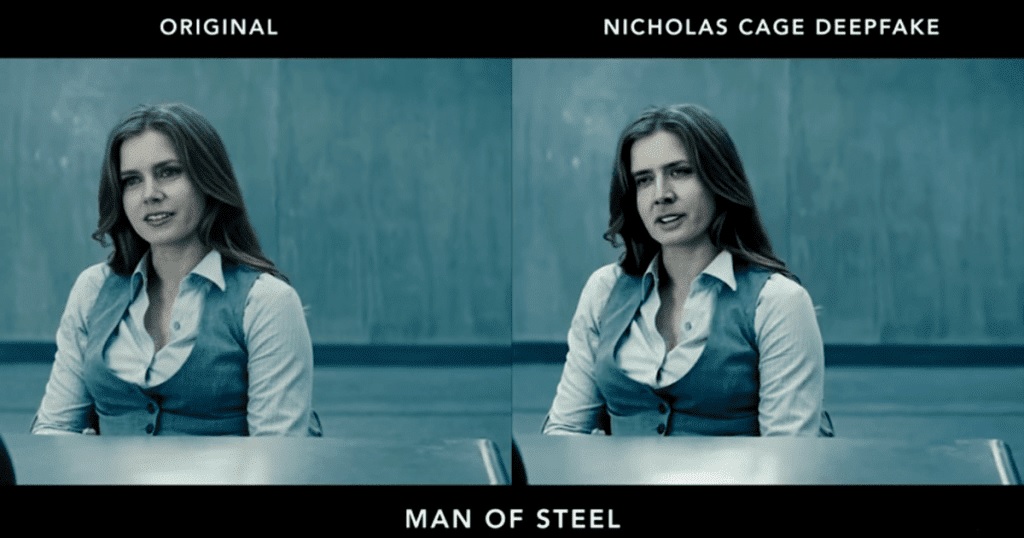

Метод обмана заключается во встраивании специальных «конкурирующих» примеров (можно перевести и как «противостоящих» — adversarial examples) в каждый кадр ролика. Эффект получается поистине обескураживающим: даже наспех состряпанный дипфейк определяется детектором как реальная запись. Хотя неестественность поведения человека на видео очевидна невооруженным глазом. Пример такого обмана исследователи продемонстрировали на практике.

Что важно, «обманка» работает при перекодировании видео и на множестве самых совершенных детекторов. Фактически специалисты делают вывод, что из-за особенностей выявляющих подделку алгоритмов их все реально легко обвести вокруг пальца.

Подобные разработки могут стать гораздо совершеннее, что снова ставит под вопрос само понятие доверия к видеоряду. А точнее, вызывает опасения, что манипуляции общественным мнением могут оказаться гораздо проще для злоумышленников, чем того хотели бы правоохранительные органы и сами люди. И если поначалу волна дипфейков воспринималась лишь как развлечение, то несколько позднее стала очевидна опасность технологии.

Люди привыкли доверять тому, что видят глазами, а добротно сделанный дипфейк может быть неотличим от реального видео. Порой достаточно даже не заменять лицо человеку, а синхронизировать движения губ с поддельной речью. Масштабы возможного применения таких манипуляций поистине безграничны. И детекторы подобных подделок разрабатывают сотни коллективов по всему миру.

Свежий пример: как сообщает РБК, Министерство внутренних дел России объявило тендер на создание алгоритма для выявления «внутрикадрового монтажа». Сумма контракта составляет почти 4,8 миллиона рублей, но эти средства, скорее всего, будут потрачены впустую. Американские исследователи показали, что создание «необнаружимых» дипфейков было лишь вопросом времени. Разработчикам защитных инструментов придется искать совершенно новые способы определять подделки — и этот процесс может занять очень много времени.