Американские психологи проверили способность большой языковой модели GPT-3 решать незнакомые для нее задачи методом аналогии. Это классический подход к определению интеллектуального развития людей, и нейросетевой алгоритм показал себя с неожиданной стороны. Он дал больше правильных ответов в адаптированном тесте стандартными прогрессивными матрицами Рейвена, чем студенты старших курсов колледжа.

Заставлять нейросети делать что-нибудь, для чего они изначально не предназначались — интересное развлечение, с которым после открытия доступа к языковым моделям вроде ChatGPT познакомился едва ли не каждый пользователь интернета. Однако подобные действия могут иметь и вполне научное обоснование. Тестируя генеративный искусственный интеллект на грани его возможностей, ученые ищут способы познания человеческого разума.

Пожалуй, самое впечатляющее в алгоритмах семейства GPT-3 — их способность решать те или иные новые задачи с минимум примеров (Zero-shot). Главное — описать проблему текстом.

Такая механика мышления — изучить один-два образца, провести аналогию с новой, совсем незнакомой, но похожей ситуацией и найти из нее выход — называется аналоговым, или аналогичным, рассуждением (analogical reasoning). Имеется в виду «рассуждение» как часть мышления, а не вербализация. И считается, что это уникальная особенность людей. Может быть, еще и некоторых наиболее интеллектуально развитых видов животных.

Исследователи из Калифорнийского университета в Лос-Анджелесе (UCLA) задались вопросом, действительно ли GPT-3 может рассуждать по аналогии. Для этого они выбрали задачи, с которыми модель точно не встречалась во время обучения.

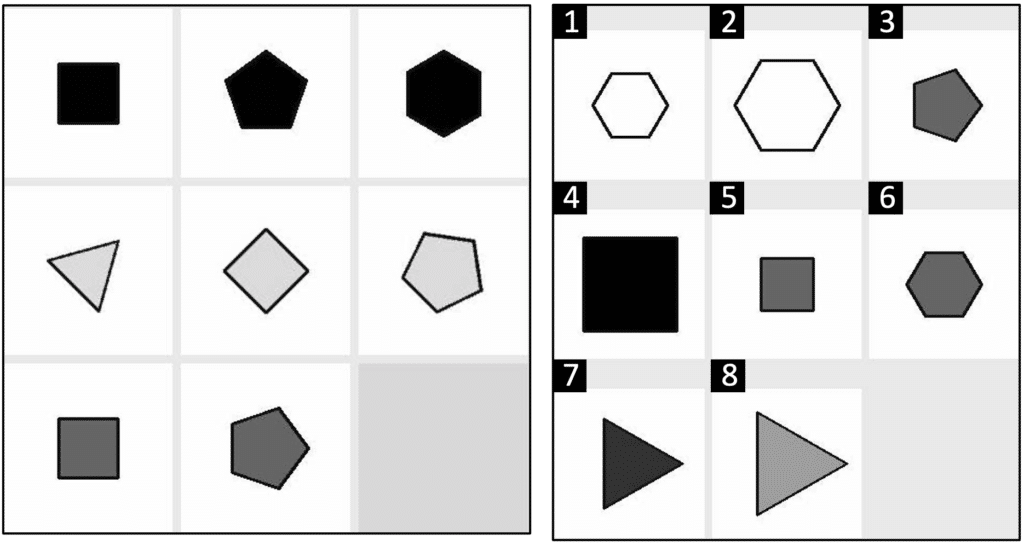

Ученые адаптировали для работающего с текстом искусственного интеллекта проверенные временем карточки теста стандартными прогрессивными матрицами Рейвена.

Это серии изображений из девяти элементов, сгруппированных по три, с пропущенной девятой ячейкой. Испытуемому предлагается выбрать из нескольких вариантов ответа правильный. Фигуры имеют несколько свойств, которые в каждом ряду изменяются по набору правил. Чтобы ответить верно, нужно, глядя на первые два ряда, определить правила и, проведя аналогию, применить их к третьему ряду. На словах непросто, но визуально воспринимается легко (смотрите иллюстрацию). С каждым следующим заданием сложность возрастает.

Поскольку GPT-3 не мультимодальная модель, то есть умеет работать только с текстом, матрицы адаптировали, но принцип остался тот же. В качестве контрольной группы выступали учащиеся колледжа UCLA. И они проиграли искусственному интеллекту.

Студенты дали чуть менее 60 процентов правильных ответов (нормальный уровень), GPT-3 — 80 процентов (больше среднего для людей, но в рамках нормы). Как отметили авторы исследования, алгоритм совершал те же ошибки, что и человек. Иными словами, высока вероятность, что процесс принятия решений был очень похожим.

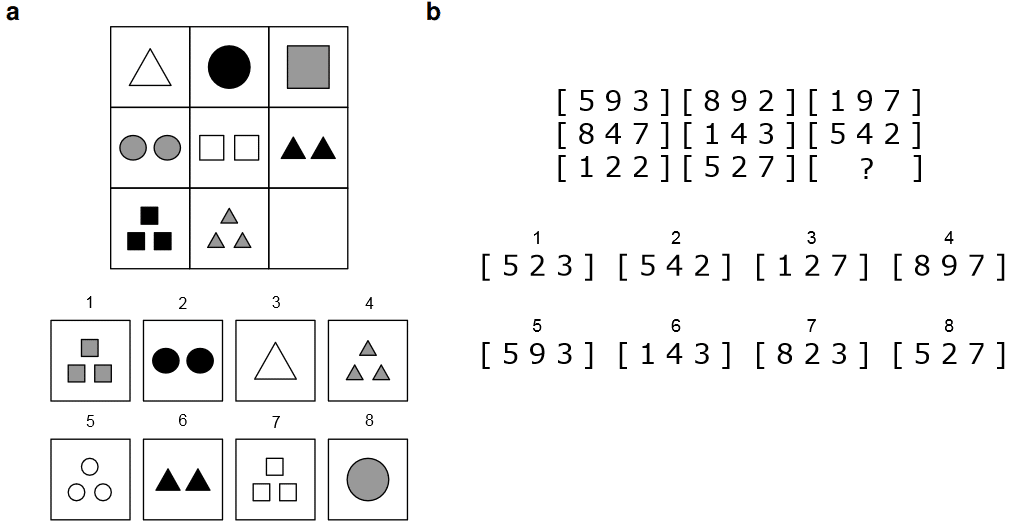

В дополнение к матрицам Рейвена исследователи дали алгоритму задачи из стандартизированного теста для приема в высшие учебные заведения США (SAT). Большая часть его вариантов никогда не публиковалась в открытом доступе, так что GPT-3, скорее всего, с ними тоже не знаком.

Модель показала высокие результаты (наравне или лучше контрольной группы людей) в заданиях вида «„любовь“ для „ненависти“ — то же, что „богатство“ для этого слова, какого?» (правильный ответ — «бедности»). Таким образом, алгоритм должен был понять, что от него требуется найти в этом случае антоним, без прямого указания на то.

Ожидаемо GPT-3 хорошо решил и более трудные вопросы, в которых аналогии нужно было провести между целыми предложениями или абзацами. А вот где модель предсказуемо села в лужу, так это в задачах на пространственное мышление.

Даже если подробно описать проблему вроде «чем лучше переложить жевательные конфеты из одной миски в другую — трубкой, ножницами или лентой», алгоритм предлагал бессмысленные тексты в ответ.

Проведенное американскими психологами исследование на новом уровне поднимает вопрос: имитируют ли большие языковые модели ряд аспектов человеческого мышления, либо перед нами совершенно новый тип мышления? Во втором случае сама собой напрашивается аналогия со знаменитым философским концептом «призрака в машине». По одной из его интерпретаций, достаточно сложноустроенная искусственная система (машина) может обретать новые непредвиденные свойства, которые со стороны будут неотличимы от человеческого сознания.

У научной работы есть два существенных ограничения, на которые ее авторы справедливо указывают. В первую очередь, несмотря на старания исследователей, нет никаких гарантий, что GPT-3 во время обучения сталкивался с задачами, похожими на вышеописанные. Наименее вероятно, что модель тренировали на текстовых представлениях прогрессивных матриц Рейвена. Наиболее — что какие-то варианты SAT могли встречаться в наборе данных для обучения.

Из этого вытекает вторая проблема: ученые не обладают доступом к «внутренностям» модели, из-за чего процессы ее «мышления» представляют собой черный ящик. А это сдерживает нейронауки в развитии.

Научная статья с подробным описанием исследования опубликована в журнале Nature Human Behaviour. Ее препринт (неотрецензированная версия) размещен в открытом доступе на портале arXiv.