Развитие производительности видеопроцессоров формирует будущее сегмента искусственного интеллекта. В настоящее время Nvidia лидирует в области чипов для ИИ, поставляя почти 90% графических процессоров, оптимизированных для приложений ИИ. Усиливая свою позицию, компания недавно анонсировала новый «суперчип» GH200, выпуск которого запланирован на второй квартал следующего года. По утверждению компании, он значительно снизит затраты на эксплуатацию больших языковых моделей, таких как GPT или Bard.

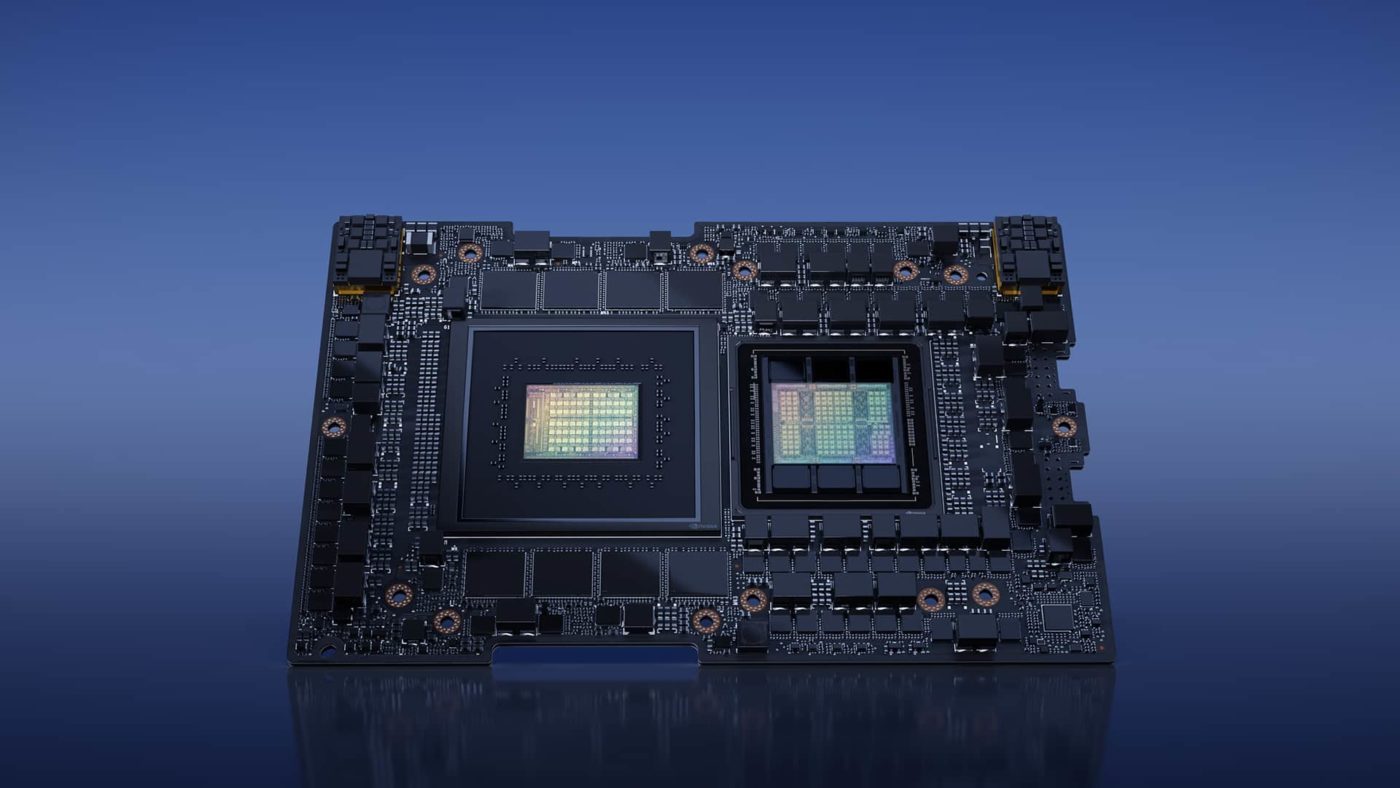

Повышение числа крупных моделей ИИ, включая большие языковые модели (LLM), привело к стремительному росту спроса на вычислительные ресурсы. Графические процессоры с множеством ядер могут выполнять массу вычислений одновременно. Не случайно, что эталонные тесты ИИ, например Bard от Google и ChatGPT от OpenAI, теперь используют эти технологии. На фоне растущего спроса компания Nvidia, всегда лидирующая в области инноваций, представила новый чип GH200 Grace Hopper.

Огромный прорыв в сфере технологии хранения данных.

Новая платформа Nvidia – первая в мире с процессором HBM3e. Технология памяти HBM (High Bandwidth Memory) известна исключительной пропускной способностью при оптимизированном энергопотреблении. Версия HBM3e от Nvidia открывает новые возможности.

Микросхема памяти HBM3e объемом 282 ГБ на 50% быстрее предшественницы HBM3 и обеспечивает суммарную пропускную способность 10 ТБ/с, что позволяет чипу GH200 работать с моделями искусственного интеллекта в 3,5 раза большего объема, чем у технологии HBM3.

Такая емкость памяти позволяет разместить масштабированную модель ИИ на одном графическом процессоре. Для достижения подобной производительности обычно применяют несколько GPU, что влечет за собой увеличение расходов и сложности.

Суперчип, предназначенный для вычислений

Взаимодействие с искусственным интеллектом происходит в два этапа: обучение и применение. На этапе обучения модель искусственного интеллекта воспринимает информацию и тренируется на больших объёмах данных. Именно в этот период модель постигает и улучшает свои способности.

После обучения модель переходит к фазе вывода. В этот период ее проверяют на практике, заставляя генерировать прогнозы, текст, изображения или другие виды контента на основе полученных знаний. Каждый запуск ПО с искусственным интеллектом, каждый прогноз и генерация требуют мощных вычислительных ресурсов. Именно в этой области GH200 проявляет превосходство.

Nvidia на презентации заявила, что новый суперчип GH200 оптимизирован для вычислительных задач в области выводов. Несмотря на то, что подобные операции часто бывают затратными с точки зрения энергии, Nvidia утверждает, что GH200 позволит значительно снизить энергопотребление при работе с крупными моделями. В итоге вычисления с GH200 становятся не только более быстрыми, но и экономичными.