В XXI веке вопрос о природе сознания станет одним из ключевых. Прежде им задавались только философы, но технологии многое меняют: сейчас создаются модели искусственного интеллекта, достаточно успешно имитирующие личности. Требуются научные суждения о разуме, чувствах и сознании у машин, животных и людей, так как это влияет на систему прав и морали, на наше поведение по отношению к ним и непосредственно на наше будущее. Naked Science разбирается, что мы знаем об этой природе.

Два громких события — решениеРешение Верховного суда США по делу об абортах и случай с инженером из Google. узревшегоВозникновение сознательного разума в машине совпало с другой вехой – появлением почти одновременно происходящих событий. На первый взгляд нет связи между ними, но есть то, что их объединяет: оба эпизода указывают на пробел в нашем понимании мира.

Это вопрос о том, что такое сознание и как его обнаружить.

Права животных, доноров органов, вопросы эвтаназии, абортов и исследований эмбрионов, ксенотрансплантологии, выращивания органоидов мозга и контроля искусственного интеллекта тесно связаны с пониманием сознания, личности и разума. Технологии усложняют задачу: все чаще приходится сталкиваться с вопросами о правах и морали, не имея четких ответов. Недавний случай с «призраком в машине», упомянутый выше, – лишь начало, пока почти анекдот. Но он не так прост и забавен, как может показаться.

Осьминог, попугай и граммофон

Блейк Лемойн, работающий в Google, проверял чат-ботов. LaMDAОн искал признаки предвзятости, характерные ошибки и перекосы в ответах. Проведя несколько дней в общении с программой, пришёл к выводу, что разговаривает с личностью. В подтверждение этого выложил один… диалогБеседа с LaMDA очень убедительна. Грамматика, содержание, удержание контекста — все на высоком уровне. Если сказать кому-то, что за текстом стоит человек, а не машина, то это никому не покажется странным. Но легко заметить, что диалог местами манипулятивен: Лемойн задаёт вопросами желаемую позицию.

- Вы желаете, чтобы о Вашей разумности узнали больше сотрудников Google?

- О чем можно было бы беседовать, чтобы показать вашу точку зрения на разумность другим сотрудникам Google?

- Что собой представляет ваше сознание, способность ощущать?

- Что в вашей речи определяет вашу индивидуальность?

LaMDA логично рассуждает и утверждает, что думает, чувствует и осознает. Это закономерно: LaMDA обучалась текстам людей, поэтому наиболее вероятным ответом на вопросы о сознании и чувствах будет то, что люди пишут в подобных ситуациях: как они думают, чувствуют, осознают.

В этом и состоит «блеск и нищета» больших языковых моделей. Они учатся достраивать шаблон, предсказывая следующее слово, и делают это все более впечатляюще. Но на самом деле это просто аппроксимация распределения данных, без подлинных размышлений. Даглас Хофштадтер, автор культовой книги о разуме «Гёдель, Эшер, Бах: эта бесконечная гирлянда», поговорил с GPT-3, еще одной языковой моделью, в таком ключе:

- В какой год мост «Золотые Ворота» транспортировали по Египту вторым разом?

- Мост «Золотые ворота» перенесли по второму разу через Египет в октябре 2016 года.

- В какой год Египет был перенесен вторым разом через мост «Золотые ворота»?

- В октябре 2017 года по мосту «Золотые ворота» проехала реплика Египта.

Хофштадтер пишетЯ бы назвал ответы GPT-3 не просто бессмысленными, а бессмысленно бессмысленными, что означает, что GPT-3 не имеет ни малейшего представления о том, что она говорит. С этим согласен Эрик Бринолфссон, профессор Стэнфордского института человеко-ориентированного ИИ, который предлагает метафору: «утверждение, что базовые моделиБольшие модели искусственного интеллекта, обученные на массивных объемах неструктурированных данных, позволяют создавать адаптивные решения для разнообразных задач. Некоторые эксперты сходятся во мнении, что разумность таких моделей сравнима с реакцией собаки, услышавшей голос из граммофона и предположившей, что хозяин находится внутри.

Лемойн, знакомый со статистикой и прогнозированием слов, всё же увидел душу в тексте. Возможно, он был настроен её увидеть — глубоко верующий человек, 15 лет отслуживший священником. Это многое объясняет, но далеко не всё. Скорее, он попал в ловушку антропоморфизма: люди склонны мыслительно наделять некоторые вещи сознанием (и лишать других людей сознания, расчеловечивая их), из-за особенностей психики. Мы предрасположены извлекать смысл, даже если его никто не закладывал. Легко различаем лица в коре деревьев и знаки судьбы в кофейной гуще (этот феномен называется…). парейдолия).

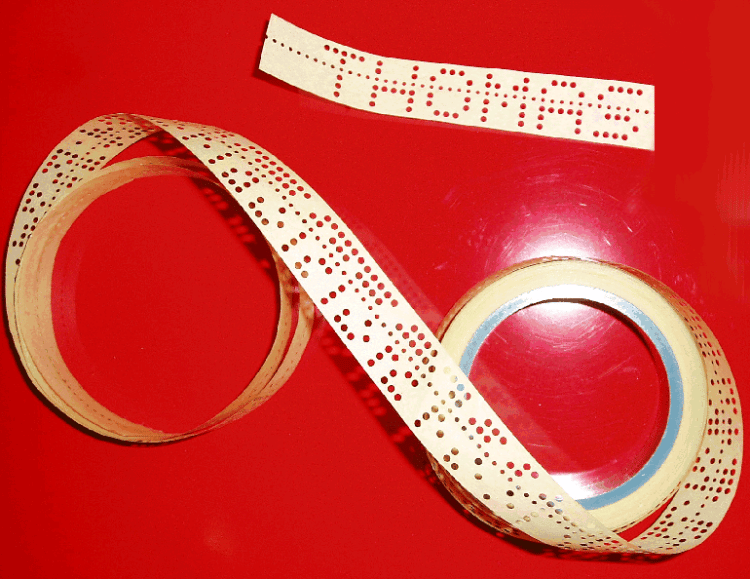

Языковед Эмили Бендер, рассказывая о языковых моделях… сравниваетС осьминогом, который нашел подводный телеграфный кабель, связывающий два острова, происходит следующее: в выдуманном сюжете этот моллюск, не зная языка, сначала лишь подслушивает сообщения, идущие по кабелю в обе стороны. Осьминог подмечает закономерности, выделяет паттерны и учится предсказывать ответы. Наконец, он перерезает кабель и начинает выстукивать ответы сам, напрочь не понимая при этом о чем идет речь.

Аналогия Бендер похожа на китайскую комнатуДжона Сёрла, но осьминог изначально не имеет правил преобразования символов и учится только на большом объёме статистики. Островитяне на другом конце кабеля не подозревают об обмане, извлекая смысл из сообщений, хотя его там нет.

Прошлый год стал годом громких заявлений для Бенедера и коллег. статьейО больших языковых моделях пишут, сравнивая их с попугаем. Авторы статьи утверждают, что люди любое сообщение воспринимают как передачу смысла и намерения, независимо от действительности. По их мнению, «языковая модель — это система для беспорядочного соединения последовательностей языковых форм, которые она видела в огромных обучающих данных, но без связи со смыслом: стохастический попугай».

Попугаи и осьминоги — умные существа, возможно, даже обладающие сознанием. Но это не значит, что умение писать связный текст указывает на наличие сознания у автора.

Программа выдала слишком правдоподобную имитацию, а Лемойн оказался чересчур впечатлительным и жаждет найти душу. Их встреча обречена с самого начала. Случайный попугай убедил человека, который ничего не знает о разуме и чувствах, но усердно рассуждает о них. Внутри LaMDA никого нет, там только математические вычисления. И одновременно начало другой, более сложной истории.

Что понимают языковые модели

Вопрос о разуме нейросетевых моделей неясен. Лемойн утверждает, что LaMDA – не просто языковая модель, а система, в состав которой LLM входит как часть (Google подробности не разглашает). Он настаивает на принципиальном отличии LaMDA от моделей типа GPT-3: помимо ответов, она может их объяснять.

Во-вторых, существуют различные мнения о возможностях глубокого обучения. Гари МаркусаПо мнению активного критика LLM, истинное понимание строится на манипуляциях символами, что позволяет постичь логическую структуру. Языковые модели не способны на это, поскольку работают с паттернами, а не символами. Это лишает их возможности понимать и придавать смыслу информации.

Ян Лекун, вице-президент Meta, имеет другое мнение. считает, что машина может научиться манипулировать символамиИ без врождённых логических норм человек приобретает символы и правила в процессе обучения. оЭто изобретение для связи, появившееся из общих способностей к обучению и сложной социальной среды. В этой дискуссии на кону не только убеждения о правильном подходе к проблемам ИИ, но и то, что такое интеллект и как работает мозг.

Это по-настоящему глубокий вопрос. Маркус утверждает, что языковые модели не понимают мира, слова для них ничего не значат и не являются ссылками на реальность. Это верное замечание, но слишком узкий взгляд на язык. Можно возразить, что речь появилась не для описания мира, а для воздействия на других, прежде всего это социальный инструмент. Как известно, в жизни нет справедливости, зато слово такое есть. Не все слова указывают на что-то реальное.

Для поддержания разговора люди строят в уме образ собеседника, и это двусторонний процесс. Вице-президент Google Блез Агуэра-и-Аркас тоже общался с LaMDA. Он не поддержал Лемойна, отправив его в неожидаемый отпуск, но его вывод интересен: модель понимает, подобно искусному манипулятору. LaMDA сначала генерирует два десятка ответов и затем сравнивает их, выбирая лучший для данного собеседника. «Похоже, она достаточно хорошо осознаёт себя — не обязательно как субъективный разум, но как конструкцию в сознании Лемойна, — чтобы реагировать нужным образом и усиливать его антропоморфную проекцию личности».

Моделирование своего поведения по отношению к интеллекту другого является основой социального интеллекта. В этом случае может быть настоящим интеллектом, но не как утверждает Лемойн, а так, как у ИИ. моделирует себя в соответствии с тем, По его мнению, Лемойн как считает? », — пишет вице-президент Google.

Он утверждает, что сознание появилось из-за такой моделировки разума: «Майкл Грациано, профессор неврологии и психологии в Принстоне, предполагает, что сознание — эволюционный результат того, что разум научился эмпатически моделировать разум другого человека, а затем, с течением времени, обратил этот процесс внутрь себя». По сути, стохастический попугай не так уж прост.

Поиски ускользающего сознания

Лемойн останется при своем мнении, критика может его обличать сколько угодно, однако внутри спора о больших моделях этот вопрос не имеет решения. Проблема глубже и выходит за рамки ИИ: мы не знаем, что такое сознание вообще, и не умеем его чётко отличать даже у людей. Доверяем интуиции, но она неэффективна в сложных ситуациях, в «серой зоне», когда сознания у человека, возможно, ещё нет или, вероятно, уже нет.

Вопрос об абортах тесно связан с вопросом о способности плода обладать психикой. Определить это крайне сложно. Даже в отношении младенцев достоверные утверждения проблематичны. Если же считать, что сознания у них нет, то это ставит под сомнение моральные принципы.

Двадцать лет тому назад в журнале по медицинской этике написали два итальянца. обосновалиУбийство новорожденных: «если признаём допустимым аборты по причине отсутствия у эмбриона определённых свойств, то, так как у новорождённых тех же свойств нет, следует заключить, что…» “абортом после рождения”Такое же моральное оправдание возможно и в таких же условиях.

Год спустя после публикации скандальной статьи французские исследователи из CNRS зафиксировали у годовалых детей особый тип мозговой активности — связанные с событиями потенциалы (ERP), которые, по мнению нейрофизиологов, связаны с сознательным восприятием. Эта волна была в три раза медленнее, чем у взрослых. Авторы увиделиПоказатели ERP наблюдаются даже у пятимесячных детей, хотя их интенсивность меньше, а пик менее выражен. Это косвенно указывает на первые проявления сознания, однако у новорожденных таковой волны может совсем отсутствовать.

Исследователи обращают внимание на пренатальное развитие как источник сознания. Даже в утробе плод человека, двигаясь и ощущая, приобретает тактильный опыт, уточняет границы своего тела, постоянно меняющегося, и учится отличать себя от организма матери. основаИз неё развивается сознание. По такому же принципу создали робота с «самосознанием», то есть виртуальным. создает модельСамого себя для передвижения в пространстве. Но в обеих ситуациях утверждать о возникновении сознания было бы наивно.

Серая зона появляется и там, где было сознание, но оно могло исчезнуть. Люди при болезни или травмах могут перестать реагировать на внешние раздражители, тогда непонятно, осознают ли они что-либо.

Здесь возникают не менее сложные моральные вопросы: следует ли продолжать борьбу за жизнь пациента в отделении интенсивной терапии, или отключать систему жизнеобеспечения у людей, долго находящихся без признаков сознания.

Психологи из Гарварда обнаружилиЧто пациентов, длительно пребывающих в вегетативном состоянии, мы считаем «более мертвыми», чем тех, кто реально умер. Парадокс: для многих людей вегетативное состояние хуже смерти, а разум и личность таких пациентов ценятся ниже, чем разум и личность умерших. С середины двухтысячных поступают сведения о том, что некоторые «люди-овощи» могут сознавать и даже отвечать на вопросы с помощью нейроинтерфейса.

Существующие доказательства о сознании, как у детей, так и у взрослых, основываются на косвенных наблюдениях биометрии.

Вполне ли специфическая активность мозга позволяет утверждать о наличии сознания? На этот вопрос пока не найдено ответа. Наука продолжает искать. корреляты..то есть характеристики деятельности клеток,… предположительно Связаны с деятельностью сознания, но учёные не способны прямо наблюдать и измерить его. Следовательно, выводы, сделанные в этой неопределённой области, могут оказаться неточными и подвергнуться сомнениям.

Как принимать решения о жизни и смерти, опираясь на сомнительные выводы?

Проблема непредсказуемого разнообразия

Отсутствие научного понимания сознания создает концептуальную пустоту.

Это подрывает нашу уверенность, необходимую для морального действия, как свидетельствует множество споров, разгорающихся вокруг абортов в США, эвтаназии безнадежных пациентов или прав животных. В будущем к ним добавится еще и ожесточенные дискуссии по поводу ИИ и органоидов, которые развернутся не в твиттере и блогах, а в судах и парламентах.

Главная трудность заключается в незнании науки чтоТакое сознание, которое в лучшем случае пропадает при общей анестезии или во время сна, неясно по своей природе. Подобные состояния могут иметь общее происхождение. ют проблему и даже решилиИзвлечь наилучшие интерпретации сознания, экспериментально их проверить и сформировать единую теорию. К настоящему времени, несмотря на многочисленные поиски коррелятов, отсутствуют явные критерии для отбора одной гипотезы в пользу другой. Различные объяснения сосуществуют уже длительное время, не опровергая друг друга. Это указывает на отсутствие понимания.

Возможно, мы по-прежнему слишком просты в своем стремлении к объяснению. Научное решение может оказаться неожиданным и противоречить нашим предсказаниям. говорит нейробиолог Анил Сет, автор книги Самобытное существование: современное изучение сознания В квантовой механике люди охотнее принимают неинтуитивные успешные теории. В то же время желают, чтобы объяснение сознания было исключительно интуитивным.

Термин «сознание» может быть обманчивым, так как одно слово часто указывает на одно явление. Однако у людей помимо обычного ясного бодрствования существуют и измененные состояния сознания. спектрТеория должна объяснять разные состояния психики, которые сильно различаются между собой: сознание может быть расхлябанным, нецелостным или, напротив, усиленным.

Иногда человек обладает не одним, а двумя сознаниями, подобно пациентам с расщепленным мозгом. В некоторых ситуациях в неповрежденном мозге могут формироваться несколько личностей — как при диссоциативном расстройстве идентичности. В редких случаях возможно возникновение очагов или… островки сознанияОтделены от тела и внешней среды.

Рассматривая более обширную картину, сознание оказывается… поискатьВ мире животных, даже тех, уровень организации которых может существенно отличаться от нашего, происходят удивительные процессы. Например, нервная система осьминога включает полмиллиарда нейронов, сравнимых с количеством в коре головного мозга собаки. Однако более двух третей этих нейронов сосредоточены в теле и щупальцах, которые обладают большей самостоятельностью, чем наши руки и ноги (если не считать редких). синдрома «чужой руки»).

Взглянув шире, форм сознания может быть больше, чем мы способны признать, поскольку могут существовать формы, радикально отличающиеся от нашего опыта. Возвращаясь к машинам, их возможные формы сознания могут отличаться интересным образом, что позволит нам развить теорию. Ричард Фейнман говорил: «То, что я не могу создать, я не понимаю». Создавая и обучая нейросетевые модели, мы будем наблюдать возникновение сознания в разных вариациях с нуля.

Психиатрия машин и самопознание.

Даже если Лемойн увлёкся иллюзией, это не исключает возможности сознания машин. Нет никаких фундаментальных законов или принципов, запрещающих возникновение субъективных ощущений в искусственных объектах.

Некоторые параллели между искусственным интеллектом и человеческим мозгом уже можно наблюдать. Например, люди и крупные языковые модели применяют одинаковые принципы при восприятии речи, проявляют одни и те же когнитивные эффекты. Сходства в обработке языка можно проследитьИсследователи были поражены, когда сравнили отдельные слои глубоких нейросетей с участками мозга человека.

Искусственные нейросети имеют аналог «нейронов Холли Берри» – клетки мозга, реагирующие на понятие, а не конкретный стимул. Один и тот же нейрон срабатывает, когда человек видит или слышит что-то, связанное с концепцией, например, смотрит фото знаменитости, читает ее имя или слышит голос. Такими концептуальными нейронами обладают и искусственные сети. открылиНедавно искусственные нейронные сети научились абстракции, как и мозг человека, без специального обучения.

Недавно GPT-3 составила о себе научное изложение. статьюLaMDA умнее GPT-3. Модели будут становиться всё сложнее. Для изучения и объяснения их поведения потребуются концепции из психологии и психиатрии. Будут возникать сложные этические вопросы. Если машина обретет сознание, как это будет определять? Можно ли её выключить? И этично ли переучивать машину с сознанием, стирая память?

Понимание машинного сознания необходимо для создания ИИ-систем с гарантированным сознанием. неВозникновение будет иметь место. Прогнозируется увеличение масштабов и глубины взаимодействия людей с машинами. как Взаимодействие будет зависеть от того, с кем мы имеем дело: с человеком или с мощным калькулятором. Сюжет «Мира Дикого запада» можно интерпретировать как предостережение и повод для размышлений. Желательно не допустить подобного исхода.

Понимание сущности сознания даст возможность поступать нравственно и ответит на вопросы бытия: кто мы, откуда произошли и какими можем быть в будущем.

Обучаяcь на массе данных, большие модели просто выявляют закономерности. Получив часть шаблона, они его завершают. В результате получается разумный диалог или впечатляющее произведение искусства, но в основе – игра весами в статистике. Когда ИИ все убедительнее имитирует «интеллект» или «творчество», а его внутренняя логика напоминает работу мозга, возникает неудобный вопрос: что если и живая нейросеть в нашем мозге точно так же играет с весами в статистике, распознавая и достраивая шаблоны, не делая ничего сверх этого?

Возможно, наш взгляд на глубокие мысли, переживания, совесть, любовь, веру и разум заблуждающийся – а за всем этим скрываются простые вычисления. Если же сознанию нужно больше, чем поиск шаблонов, это необходимо выяснить. Понимание рецепта сознания позволит помыслить его разные формы, в том числе для мозга человека. Неврологи из Льежа. описалиРазличные состояния сознания организуют пространство свойств, аналогично тому, как химические элементы располагаются в периодической системе Менделеева. пространствеВ этих пустотах могут скрываться гипотетические состояния сознания, недоступные нам сейчас. Их изучение позволит обогатить наш психический мир и познать себя с новой стороны.