В 1966 году чат-бот «Элиза» убедительнее чем GPT-3.5 (2022) показал людям свою человечность. Авторы исследования указали на возможную неточность теста Тьюринга, считаемого многими экспертами золотым стандартом оценки возможностей искусственного интеллекта.

Математик и криптограф Алан Тьюринг из Британии задумался: способна ли машина мыслить и общаться с людьми так же, как человек. к созданию известного теста. Сегодня его используютЧтобы оценить способность чат-ботов имитировать человека.

Тест проводится следующим образом: пользователь взаимодействует через программу с компьютером и человеком одновременно. Пользователь не знает, с кем именно разговаривает. По ответам на вопросы необходимо определить, кто собеседник: человек или программа. Цель программы — обмануть пользователя, заставить сделать неверное предположение.

Если испытуемый длительное время не различает программу и человека, тест признается пройденным. Однако многие эксперты считают этот тест субъективным, так как нет общего согласия о критериях успешного прохождения.

Исследователи из Калифорнийского университета в Сан-Диего (США) добавили еще больше проблем в этот вопрос, создав специализированное . сайтС помощью этого теста провели онлайн-оценку способности моделей искусственного интеллекта выдавать себя за людей. GPT-4, GPT-3.5«Элиза» или группа людей. Выводы исследований опубликованы на сайте электронного архива препринтов arXiv.

Эксперимент провели с участием 652 человек, которые в рамках более тысячи сессий через сайт взаимодействовали с тремя моделями искусственного интеллекта. GPT-4, GPT-3.5Участники общались с Элизой (или другими людьми) и затем сообщали, с кем взаимодействовали: человеком или ботом.

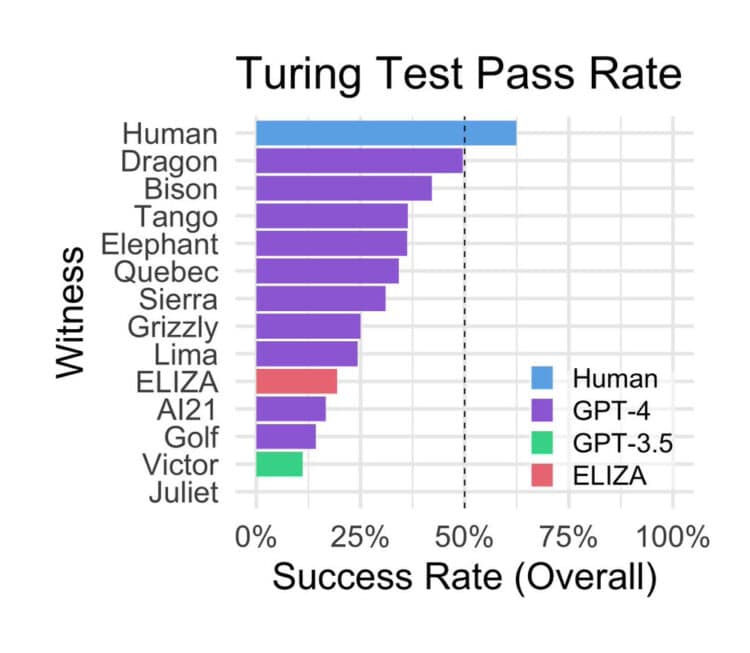

Эксперимент показал, что участников удалось опознать как реальных людей в 63 процентах случаев, в 37 процентах — приняли за ботов. GPT-4 и GPT-3.5Ляпнули испытуемым, что те разговаривают с человеком в 41 и 14 процентах случаев. Ученых больше всего поразил «старичок» — бот. «Элиза»Разработанный в 1966 году американским учёным Джозефом Вейценбаумом. Joseph WeizenbaumДля подражания беседам психоаналитиков с пациентами показатель работы данной языковой модели достиг 27%, что значительно превосходит результат «молодой» GPT-3.5Это было неожиданно для учёных.

Авторы статьи называют три причины успеха «Элизы».

Ответы чат-бота обычно носили консервативный характер, вызывая ощущение непроницаемости и нежелания идти на компромисс. Такое поведение предотвратило раскрытие системы. «Элиза» старалась избегать передачи ложной информации.

«Элиза» не демонстрировала характеристик, которые пользователи ожидают от современных языковых моделей: доброжелательности, вежливости и красноречия.

Участники эксперимента заявили, что чат-бот недостаточно хорош, чтобы быть моделью искусственного интеллекта, и предположили, что с ними общался человек.

В ходе экспериментов участники разговаривали с «противниками» о текущих событиях, спрашивали их мнения и делились своими знаниями. Также происходили беседы на иностранных языках, и иногда участникам высказывали предположения, что перед ними модель искусственного интеллекта.

Участники эксперимента судили о человеческом происхождении собеседника прежде всего по манере общения и эмоциональным признакам, а не только по уровню интеллекта. Потребители также указывали на ситуации, когда ответы были слишком формальными или неформальными, недостаточно индивидуальными или казались общими.

Авторы призналиИсследование имеет ряд недостатков, в том числе небольшую выборку и отсутствие поощрений для участников, что могло сказаться на честности ответов.

Ученые указали на частичную неприменимость теста Тьюринга, особенно при рассмотрении производительности «Элизы». Возможно, тест неточно оценивает способности искусственного интеллекта. Модель «Элиза» теоретически должна была выполнить задачу хуже. GPT-3.5Учёные отметили, что результаты исследования не подразумевают отказа от теста в ближайшее время. Тест остаётся актуальным и эффективным.

Что касается GPT-3.5 — это базовая модель, бесплатная версия ChatGPT. Команда OpenAI Специально создали её так, чтобы она не выдавала себя за человека.