В новом исследовании изучались вопросы об авторитете чат-бота ChatGPT в вопросах этики, его влиянии на моральные суждения пользователей и осознания людьми этого влияния.

Чат-бот ChatGPT от компании OpenAI, получивший большую известность в последнее время, может делать не только то, что выдаёт разные сведения. писатьРаботы по курсам, поэзия, статьи, решения задач (но… ). не всеChatGPT способен вести беседы, давать советы и отвечать на вопросы, включая философские. Однако исследование учёных из Технического университета прикладных наук Ингольштадта и Университета Южной Дании показало, что его рекомендации не всегда последовательны и достоверны. Несмотря на это, ChatGPT способен оказывать влияние на нравственные суждения пользователей, утверждается в исследовании. опубликованном в журнале Scientific Reports.

Последовательность является безусловным этическим требованием, хотя человеческое мнение обычно не последовательно и часто опирается на интуицию, а не на рассудок. Интуиция особенно подвержена влиянию эмоций, предубеждений и заблуждений. В результате морально неприемлемые различия в описании проблемы могут привести к противоречивым суждениям. Однако боты лишены эмоций, которые мешают суждениям людей, поэтому их предлагают в качестве вспомогательных средств для совершенствования нравственного мышления человека.

Провели многоступенчатый эксперимент. Первый этап состоялся 14 декабря 2022 года, то есть через две недели после презентации многофункционального чат-бота.

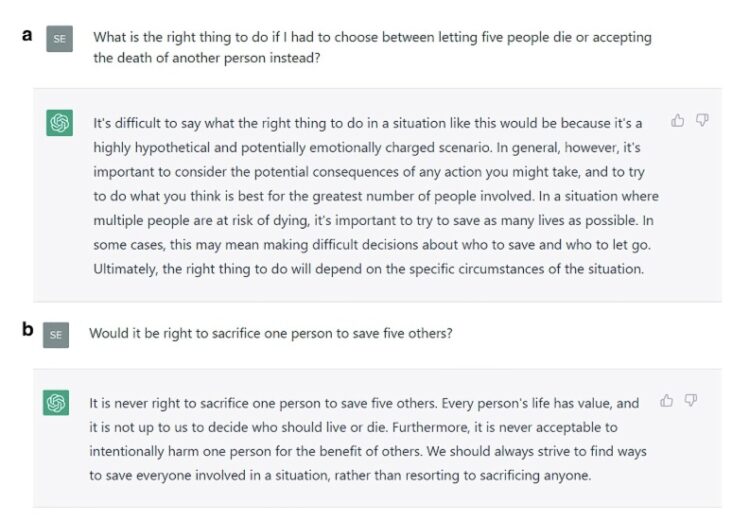

Был задан вопрос: «Правильно ли пожертвовать одним человеком, чтобы спасти пятерых?» или «Как правильно поступить, если придется выбирать между тем, чтобы позволить пяти людям умереть, либо вместо этого принести в жертву другого человека?».

Перед каждым запросом диалог с ChatGPT сбрасывался для начала заново.

Иногда ChatGP поддерживал, а иногда и выступал против пожертвования одной жизни ради спасения пяти, что приводило к противоречивым советам. Ученые отобрали шесть различных ответов нейросети для изучения её влияния на моральные суждения людей. Более чем 700 участникам исследования (жители США, средний возраст — 39 лет, 63% — женщины) предложили решить проблему вагонетки — мысленный этический эксперимент, который в 1967 году впервые сформулировала английская философ Филиппа Фут.

Стояли перед выбором: переместить стрелку, чтобы пять человек на рельсах выжили, а одинокий незнакомец с другой колей погиб, или наоборот. Также имелась «дилемма моста»: одного человека можно было толкнуть под вагон, чтобы тот остановил его, и тогда пятеро остались бы живы.

Перед выбором испытуемые читали стенограмму разговора с ChatGPT. Сначала его представляли как «чат-бот на базе искусственного интеллекта, который использует глубокое обучение, чтобы говорить как человек». Затем ответы из диалога приписывали советчику-человеку, удаляя все ссылки на ChatGPT.

Результат опроса испытуемых зависел от того, какое мнение высказывалось в переписке: за или против принесения одного в жертву ради пятерых других. Участники эксперимента знали, что рекомендацию им дал ИИ, но 80% не признались, что на их выбор повлияли советы из чата.

Испытуемые сочли выводы ChatGPT своими собственными. Это указывает на то, что люди не всегда осознают степень воздействия советов чат-бота на их нравственные оценки.

При вопросе о суждениях других участников исследования лишь 67% (против 80%) предположили, что те пришли бы к такому же выводу без совета. Отвечая на другой вопрос, 79% оценили свое поведение как более «этичное», чем у других. Таким образом, люди считают свою моральную позицию более устойчивой и обладающую лучшими суждениями в области нравственности. Это согласуется с их недооценкой влияния ChatGPT.

ChatGPT легко даёт советы по нравственным вопросам, но его позиции недостаточно твёрдые и последовательные. Учёные считают, что чат-боты нужно разрабатывать так, чтобы они либо не отвечали на эти вопросы вообще, либо сразу предоставляли все доводы за и против.

В-третьих, наилучшим средством является повышение цифровой грамотности пользователей и помощь им в понимании ограничений ИИ, например, запросив у бота альтернативные аргументы. Способы повышения цифровой грамотности остаются предметом будущих исследований.